Systémy poháněné umělou inteligencí nejenže spotřebovávají obrovské množství dat pro trénink, ale také vyžadují obrovské množství elektřiny, aby mohly fungovat. Nedávná studie vypočítala spotřebu energie a uhlíkovou stopu několika nedávných velkých jazykových modelů. Bylo zjištěno, že jeden z nich, ChatGPT, běžící na 10 000 GPU NVIDIA, spotřebovává 1 287 megawatthodin elektřiny. To je ekvivalent energie spotřebované 121 domácnostmi za rok ve Spojených státech.

Stále větší spotřeba

Jak se zrychlujeme směrem k budování jednoho z největších technologických pokroků, kterých kdy člověk dosáhl, musíme si položit otázku, jaká je kompenzace tohoto vývoje? V komentáři publikovaném v časopise Joule autor Alex de Vries tvrdí, že v budoucnu mohou energetické nároky na napájení nástrojů umělé inteligence převýšit energetické nároky některých malých národů.

„V roce 2021 byla celková spotřeba elektřiny Googlem 18,3 TWh, přičemž umělá inteligence tvořila 10–15 % z tohoto celkového počtu. Nejhorší scénář naznačuje, že samotná umělá inteligence od Googlu by mohla spotřebovat tolik elektřiny jako země, jako je Irsko (29,3 TWh ročně), což je významný nárůst ve srovnání s jeho historickou spotřebou energie související s umělou inteligencí,“ řekl Vries.

Časem bude AI spotřebovávat více energie

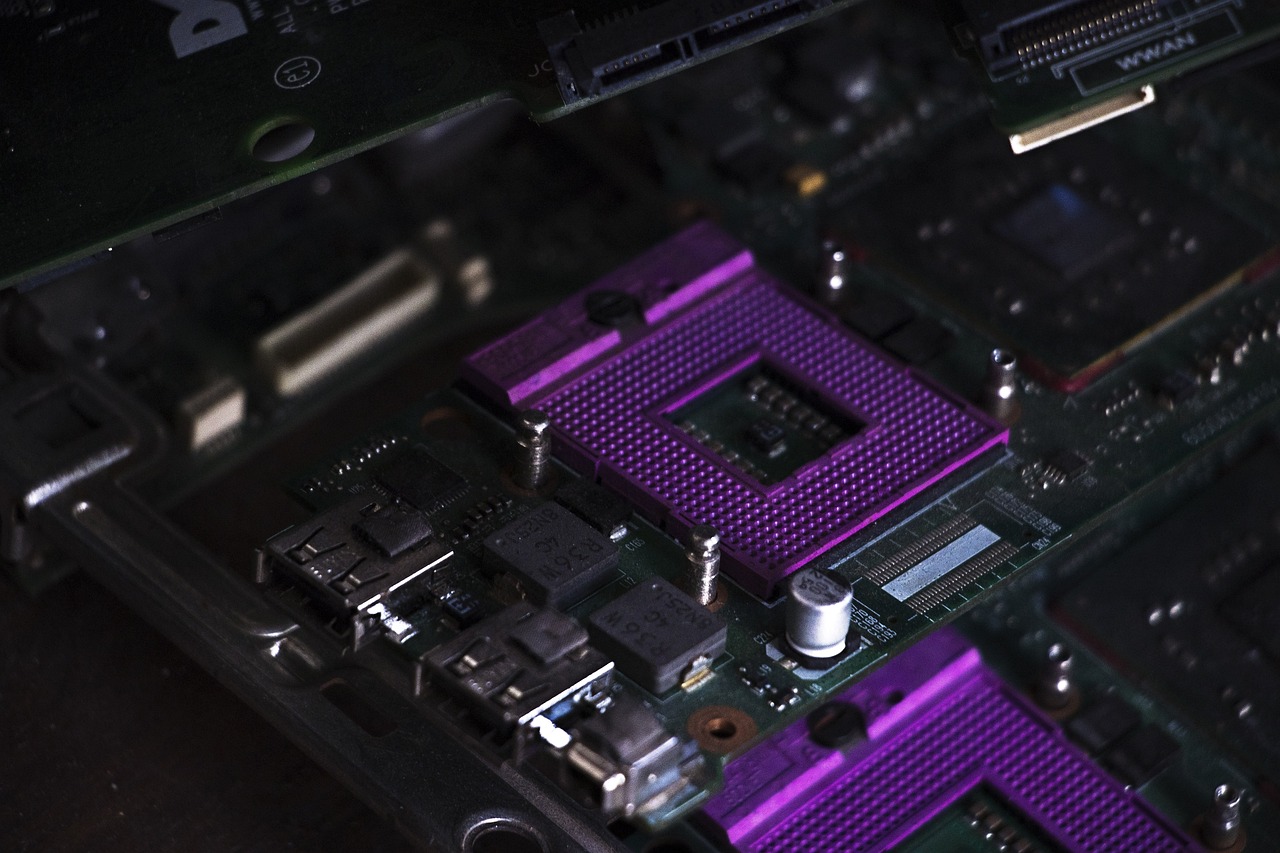

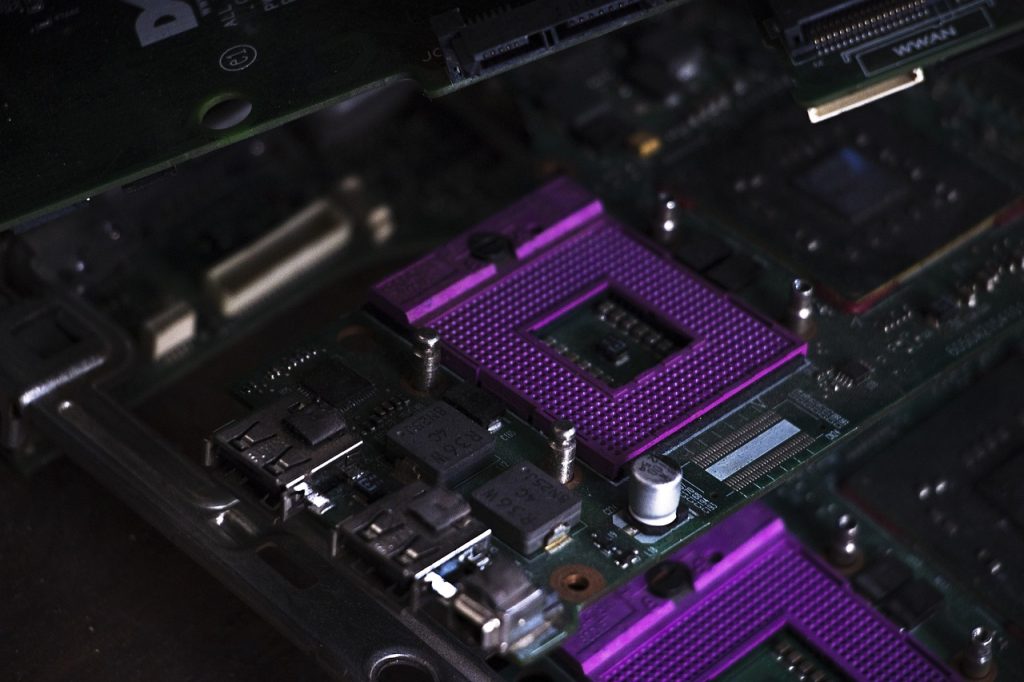

Od té doby, co společnost AI OpenAI představila ChatGPT světu na konci roku 2022, došlo k rozmachu generativní umělé inteligence. To vedlo ke zvýšení poptávky po čipech AI. Společnost NVIDIA, která je v popředí dodávek špičkových čipů, vykázala rekordní tržby ve výši 16 miliard dolarů ve čtvrtletí končícím červencem 2023. To znamená, že poptávka po čipech s umělou inteligencí pouze roste.

Nedávno také došlo k posunu ve více společnostech, které vyvíjejí své vlastní čipy, aby splnily náročné požadavky AI. Google a Amazon již mají své vlastní čipy AI, zatímco se proslýchá, že Microsoft příští měsíc představí svůj vlastní čipový hardware. Microsoft má také velké investice do OpenAI, která je podle zpráv také v počátečních fázích vývoje vlastních čipů nebo akvizice polovodičové společnosti, která to pro ně dělá.

To vše znamená, že dojde k výraznému nárůstu energetické stopy průmyslu umělé inteligence. Vries vysvětluje: „Například společnosti, jako je Google společnosti Alphabet, by mohly podstatně zvýšit svou spotřebu energie, pokud by generativní umělá inteligence byla integrována do každého vyhledávání Google.“

Další strašák spotřeby energie

Podle předního blogu SemiAnalysis o polovodičích a AI se odhaduje, že integrace chatbota podobného ChatGPT s každým vyhledáváním Google by vyžadovala 512 820 serverů NVIDIA A100 HGX, což znamená více než 4 miliony GPU. Při spotřebě 6,5 kW na server by to znamenalo denní spotřebu elektřiny 80 GWh a roční spotřebu 29,2 TWh.

Autor poznamenal, že nástroje umělé inteligence mají počáteční trénovací fázi, po níž následuje inferenční fáze. Tréninková fáze je energeticky nejnáročnější a byla dosud centrem výzkumu udržitelnosti umělé inteligence. Fáze inference je, když tyto nástroje generují výstup na základě dat, na kterých jsou trénovány. Autor vyzval vědeckou komunitu, aby této fázi věnovala větší pozornost.

„…OpenAI vyžadovalo pro podporu ChatGPT 3 617 serverů NVIDIA HGX A100 s celkem 28 936 GPU, což znamená spotřebu energie 564 MWh za den,“ řekl Vries. A to jen proto, aby se chatbot spustil dříve, než jej jakýkoli spotřebitel vůbec začne používat. “Ve srovnání s odhadovanými 1 287 MWh použitými v tréninkové fázi GPT-3 se spotřeba energie v inferenční fázi zdá podstatně vyšší,” dodal.

Autor na závěr poznamenal, že je příliš optimistické očekávat, že zlepšení v efektivitě hardwaru a softwaru plně vyrovná jakékoli dlouhodobé změny ve spotřebě elektřiny související s umělou inteligencí. I přesto je stále vyvíjeno úsilí, aby bylo využívání AI všestranně efektivní.